Неясное настоящее, ясное будущее: что важнее в обсуждении технологий

Специалист по алгоритмам Дебора Раджи призывает задуматься о том, как искусственный интеллект влияет на настоящее, а не предаваться прекрасным мечтам

Будущее

В прошлом месяце я оказалась в необычном месте. Слева сидел Илон Маск. Справа от меня за столом находился Билл Гейтс. В другом конце комнаты сидел Сатья Наделла, генеральный директор Microsoft, а недалеко от него — Эрик Шмидт, бывший генеральный директор Google. За другим концом стола сидел Сэм Альтман, глава OpenAI, компании, которая занимается разработкой ChatGPT.

В то утро все мы прибыли на первое заседание форума AI Insight Forum. Это было первое из целого ряда мероприятий, которые имеют амбициозную цель — ускорить продвижение законопроекта об искусственном интеллекте на двусторонней основе. Среди собравшихся были сенаторы, руководители технологических компаний, представители гражданского общества и я, исследователь компьютерных наук из Калифорнийского университета в Беркли. Мне было поручено представить на обсуждение результаты многолетних научных исследований в области контроля за искусственным интеллектом.

Я до сих пор не могу с уверенностью сказать, что мы достигли каких-то договоренностей. Большая часть дискуссии была сосредоточена на опасениях и обещаниях за пределами текущей ситуации — на самых серьезных опасностях и преимуществах ИИ — а не на ясном понимании того, что происходит здесь и сейчас. Размышления о будущем ИИ — это хорошо, но только если одним будущим дело не ограничивается. Но именно это и происходит, когда законодатели в спешном порядке пытаются придумать правила регулирования ИИ.

Вполне понятно, что трудности с конкретными вопросами в обсуждении ИИ отчасти связаны с широким использованием самого понятия искусственного интеллекта. Это один из тех зонтичных маркетинговых терминов, которые можно толковать и так и сяк. Согласно классификации законодательных мер, ИИ охватывает простые оценки рисков и инструменты распознавания лиц. Он входит в системы, отвечающие за принятие автоматизированных решений, и технологии дипфейка. Он распространяется на все рекомендательные системы, заложенные в онлайн-платформы, а также на все многословные и пустопорожние чат-боты. Модель «искусственного интеллекта» подразумевает просто путь от входных данных к выходным, любую ситуацию, когда, то, что вы получаете, связано с тем, что вы вводите, не благодаря тщательному анализу человека, а с помощью не всегда точных вычислений компьютера.

Как и в случае с другими бизнес-терминами, «искусственный интеллект» активно используется в рекламе технологий. На форуме руководители компаний расхваливали его сверхвозможности. ИИ может изменить систему образования, в скором времени излечить рак. ИИ был назван возможным решением проблемы бедности и голода в мире. Он может повысить производительность современного работника и произвести революцию в трудовых ресурсах. Как обычно бывает, эти почти фантастические преимущества сопровождались рассуждениями о серьезных, далеких от реальности опасностях. Некоторые участники конференции говорили о том, что злоумышленники могут использовать ИИ для производства биооружия или спровоцировать ядерную войну, особенно если модели будут находиться в свободном доступе с открытым кодом. Илон Маск назвал ИИ «обоюдоострым мечом», невероятной инопланетной технологией, которая будет настолько мощной, что может вызвать немедленную катастрофу, если попадет не в те руки.

Эта конференция была закрытой для прессы, поэтому реальная стенограмма происходившего в тот день не опубликована. По мере того как участники выходили из зала, снаружи все хотели знать: «Ну как там?». Но на самом деле некоторые спрашивали следующее: что сказали Маск и Альтман?

ИИ, безусловно, силен, и, несомненно, опасен. Но по мере того как эти точки зрения находят отклик на слушаниях в комитетах, правительственных консультативных советах, пресс-релизах и лоббистских служебных записках, становится все более очевидным, что концентрация внимания только на влиятельных корпоративных голосах является по своей сути ограниченным подходом. Проще придумать или экстраполировать контекст, чем наблюдать реальные условия. Не принимая всерьез опытную экспертную оценку другого рода, мы рискуем недооценить то влияние, которое ИИ уже оказывает на всех. Мне ли не знать: в научных кругах я сталкиваюсь с дискурсом, который столь же далек от реальности, будь то насыщенные терминологией социальные и юридические теории или сложнейшие математические уравнения и хранилища кода. Исследователи часто говорят в общих чертах и создают нереальные сценарии. Наборы данных часто далеки от общего контекста или смысла и до сих пор остаются катастрофически недокументированными. Контрольные показатели, на которые мы опираемся при оценке работы моделей ИИ, как правило, полностью оторваны от реальных приложений и последствий.

Для безопасности миллионов людей нужен более приземленный подход. В какой-то момент форума Лора Макклири, представитель латиноамериканской группы UnidosUS, поделилась историей из своего опыта, связанного с предыдущими попытками помочь образованию с помощью технологий. В ее школьном округе с низким уровнем доходов неработающим монитором компьютера подпирали дверь. Подобные истории, рассказанные другими организациями по защите гражданских прав и лидерами профсоюзов, напомнили мне о сложности ситуации. Конечно, ИИ когда-то может помочь справиться с бедностью, но он также делает людей уязвимыми для финансовых мошенников прямо сейчас. ИИ когда-то может содействовать исследованиям в области рака, но до сих пор в сфере здравоохранения его польза остается сомнительной. ИИ может повысить производительность труда, но сегодня новые рабочие места специалистов по оценке ИИ также связаны с тяжелым трудом и грубыми нарушениями трудового законодательства.

В реальных условиях продукт не всегда работает так, как ожидается. В последние годы я с изумлением читаю новости о том, что системы искусственного интеллекта оказываются не мифическими, хитроумными и непобедимыми, а приземленными, уязвимыми и ненадежными. Беременная темнокожая женщина Порша Вудрафф была арестована из-за ошибки в системе распознавания лиц. Брайан Рассел потратил годы на то, чтобы очистить свое имя от обвинений в мошенничестве с пособиями по безработице, из-за сбоя в работе алгоритма. Тэмми Доббс, пожилая женщина с церебральным параличом, из-за ошибки алгоритма лишилась ухода на дому. Давон Джексон сообщил, что из-за ложного срабатывания автоматизированной системы проверки жильцов он потерял возможность получить жилье для малоимущих, в котором его семья действительно нуждалась.

«Людям это не нужно», — сказал мне однажды Фабиан Роджерс, организатор жилищного самоуправления в Бруклине. Жильцы его многоквартирного дома спорили с домовладельцем по поводу использования программы распознавания лиц в новой системе безопасности. «Думаете, это так просто — взять человека с ребенком, думающего о квартплате и продуктах, возвращающегося после долгого рабочего дня, и внушить ему, что теперь его должно волновать что-то подобное?» — шутит он.

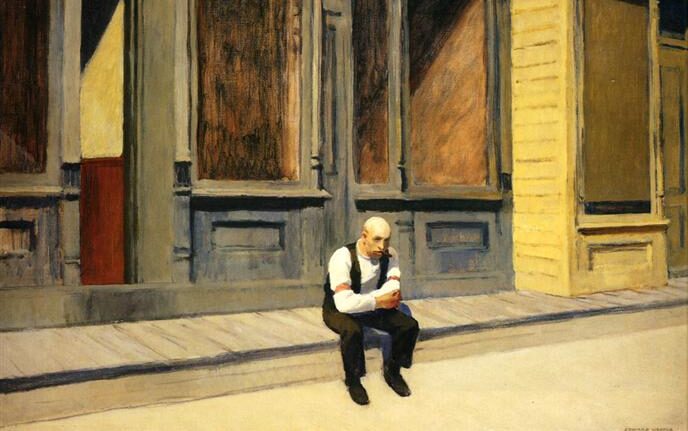

Я начинаю понимать, что имел в виду Роджерс. В день форума, организованного сенатором Шумером, не происходило никаких серьезных политических дискуссий. Не было раскрыто никаких корпоративных секретов. Это был день отстраненных вопросов и подготовленных заявлений. За годы своей адвокатской и исследовательской деятельности я не раз оказывалась в составе подобных консультативных групп, коротая проводит часы в окружении важных ответственных лиц, подглядывая в окно конференц-зала , где в щели бежевых штор видна роскошная зелень.

Правда в том, что «ИИ» не существует. Технологии, конечно, есть, но сам термин — это просто термин, приправленный жарким придыханием. Или измученным вздохом человека, уставшего и, возможно, растерянного от того, что мгновенные решения алгоритмов могут перевернуть всю его жизнь. Сейчас, когда законодатели наконец-то начинают принимать решения по ИИ, у нас есть выбор, к какому дыханию прислушиваться.

New York Times

New York Times Big Think

Big Think

Psyche

Psyche

The Guardian

The Guardian