ИИ не должен плакать: как предотвратить революцию роботов

Директор Центра когнитивных исследований Университета Тафтса Дэниел Деннет объясняет, что вовсе не обязательно — и даже вредно — делать роботов похожими на человека

Будущее

Когда отец кибернетики Норберт Винер в 1950 году написал свою книгу «Гуманное использование людей: кибернетика и общество», основным электронным структурным элементом все еще были вакуумные трубки, а реально в мире функционировало всего лишь несколько компьютеров.

Но он представлял будущее, в котором мы сейчас живем, впечатляюще подробно, и допустил всего лишь несколько явных ошибок. Больше, чем другие ранние философы искусственного интеллекта, он признавал, что ИИ не просто подражает людям и заменяет людей во многих интеллектуальных действиях, но и изменяет их в процессе. «Мы лишь водовороты в вечно текущей реке, — писал он. — Мы представляем собой не вещество, которое сохраняется, а форму строения, которая увековечивает себя».

Например, мы согласны приплатить, чтобы получить доступ к новым технологиям и расширить возможности. Но довольно скоро мы становимся настолько зависимыми от новых инструментов, что теряем способность процветать без них. Возможность становится необходимостью.

Это старая-старая история со множеством известных глав в истории эволюции. Большинство млекопитающих могут синтезировать витамин С, но приматы, выбрав диету, состоящую в основном из фруктов, утратили эту врожденную способность. Человек теперь зависит от одежды, приготовленной пищи, витаминов, прививок, кредитных карт, смартфонов и интернета. И вскоре от ИИ.

Винер предвидел некоторые проблемы такого положения вещей, которые Алан Тьюринг и другие оптимисты ИИ в значительной степени упустили из виду. По его словам, реальная опасность состоит в том, что такие машины, хотя сами по себе беспомощны, могут использоваться человеком или группой людей для усиления контроля над остальной расой. Политические лидеры могут попытаться контролировать население не с помощью самих машин, а с помощью столь же механических, как машины, политических методов.

Инновации в области цифрового аудио и видео позволяют, заплатив небольшую цену, отказаться от аналоговых форматов и обеспечить простое воспроизведение записей с почти идеальной точностью.

Но есть огромные скрытые издержки. Министерство правды Оруэлла сейчас могло бы возникнуть на самом деле. Сегодня благодаря ИИ становятся доступны методы создания поддельных видео- и аудиозаписей, которые практически невозможно отличить от настоящих. Вследствие этого те инструменты расследования, которые мы привыкли воспринимать как само собой разумеющееся в последние 150 лет, становятся устаревшими.

Откажемся ли мы от краткой эпохи фотографических доказательств и вернемся ли в прежний мир, в котором человеческая память и доверие считались золотым стандартом, или разработаем новые методы защиты и нападения в гонке вооружений правды? (Можно представить себе возвращение аналоговой пленки, хранящейся в «защищенных от взлома» системах до момента демонстрации присяжным, но сколько времени пройдет, прежде чем кто-то найдет способ поставить эти системы под сомнение?)

Один из тревожных уроков недавнего опыта заключается в том, что уничтожить репутацию гораздо дешевле, чем защитить ее. Винер говорил так: «В долгосрочной перспективе нет различия между вооружением себя и вооружением наших врагов». Информационный век — это век дезинформации.

Что же можно сделать? Ключевая фраза, как мне кажется, — это почти небрежное наблюдение Винера, что эти машины «сами по себе беспомощны». Как я уже говорил, мы создаем инструменты, а не соратинков, и очень опасно недооценивать эту разницу. Напротив, мы должны стремиться подчеркнуть ее и закрепить ее с помощью политических и правовых инноваций.

ИИ в своих нынешних проявлениях паразитирует на человеческом интеллекте. Он совершенно без разбора пожирает то, что было произведено людьми, и извлекает из этого паттерны — включая наши самые пагубные привычки. У этих машин (пока) нет целей, стратегий или возможностей для самокритики и инноваций, позволяющих им выйти за пределы своих баз данных, осознав собственное мышление и собственные цели.

Они, по словам Винера, беспомощны не потому, что скованы или ограничены, а потому что они вообще не способны «руководствоваться причинами» (как сказал Кант), им представленными. Важно продолжать в том же духе, а это потребует некоторых усилий.

В долгосрочной перспективе «сильный», универсальный искусственный интеллект в принципе возможен, но не желателен (подробнее об этом позже). Гораздо более ограниченный ИИ, который сегодня практически возможен, не обязательно станет злом. Но он представляет определенную опасность — главным образом тем, что его можно принять за сильный ИИ!

Разрыв между сегодняшними системами и научно-фантастическими изобретениями, доминирующими в воображении людей, по-прежнему огромен, хотя многие люди, как непрофессионалы, так и эксперты, недооценивают его. Давайте рассмотрим Watson от IBM.

Это результат очень масштабного процесса исследований и разработок, охватывающего столетия интеллектуального проектирования, и он потребляет в тысячи раз больше энергии, чем человеческий мозг. Его победа в Jeopardy! была настоящим триумфом, который стал возможен благодаря формальным ограничениям правил (один из компромиссов: немного отказаться от универсальности и человечности и получить шоу, радующее публику).

Но несмотря на вводящую в заблуждение рекламу от IBM, которая говорит о разговорных способностях Watson, о возможности превращения Watson в многогранного агента, это столь же трудно, как превратить ручной калькулятор в Watson. Watson скорее похож на мозжечок или миндалину, чем на разум в целом — в лучшем случае на подсистему специального назначения, которая может играть вспомогательную роль, но не затрагивает формирование целей и планов.

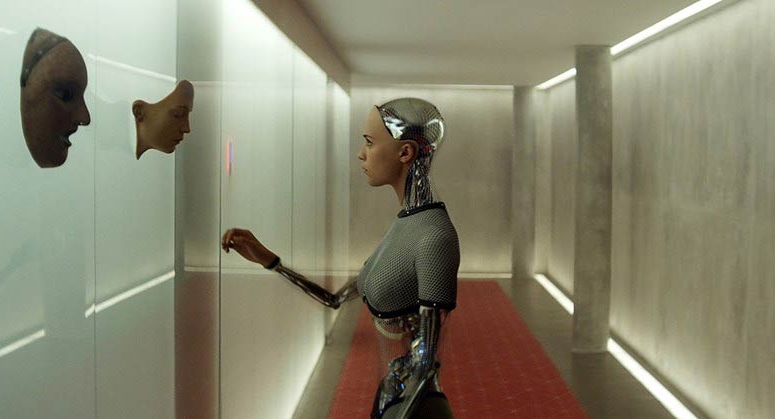

Зачем нам придавать Watson творческую автономию? Возможно, знаменитый тест Тьюринга заманил нас в ловушку, где мы стремимся создать иллюзию реального человека за экраном. С тех пор, как Тьюринг поставил перед собой задачу — которая заключалась в том, чтобы одурачить арбитров, — создатели ИИ пытаются добиться этого, придавая компьютерам мягкие человекоподобные черты, проводя своего рода диснеефикацию, призванную очаровать и разоружить непосвященных. ELIZA Джозефа Вайзенбаума, очень ранний чат-бот, была пионером такого поверхностного создания иллюзий, и Вайзенбаума смущала та легкость, с которой его смехотворно простая и поверхностная программа могла убедить людей в том, что они ведут серьезный разговор по душам.

Он был прав в своем беспокойстве. Если мы что-то и поняли из ограниченных тестов Тьюринга, проводимых в рамках ежегодной премии Лебнера, так это то, что даже очень умные люди, которые не разбираются в возможностях компьютерного программирования, легко поддаются на простые трюки.

Отношение людей из сферы ИИ к этим методам притворства в «пользовательском интерфейсе» варьировалось от презрения до торжества, с общим пониманием того, что уловки хоть и не глубоки, но могут иметь мощный эффект. И полезно было бы прямо признать, что это ложная реклама, заслуживающая осуждения, а не восторга.

Как можно этого достичь? Как только мы осознаем, что люди начинают принимать жизненно важные решения в основном на основе «советов» ИИ, чьи внутренние операции непостижимы на практике, это станет веской причиной добиться моральной и юридической подотчетности от тех, кто каким-либо образом побуждает людей доверять этим системам больше разумного.

Системы ИИ — очень мощные инструменты, настолько мощные, что даже у экспертов будет веская причина не доверять собственному суждению о «суждениях», вынесенных их инструментами. Но если пользователи этих инструментов смогут получать финансовую или другую выгоду от их использования в незнакомой области, необходимо подходить к этому ответственно, с максимальным контролем и обоснованием.

Лицензирование операторов этих систем, так же как лицензирование фармацевтов, операторов кранов и других специалистов, чьи ошибки и ошибочные суждения могут иметь тяжелые последствия, может — под давлением страховых компаний — заставить создателей ИИ очень постараться найти слабые места и недостатки в их продуктах, а также для обучения пользователей быть с ними осторожнее.

Можно представить себе нечто вроде противоположности тесту Тьюринга, в котором арбитр должен непременно обнаружить слабые места, нарушение границ, пробелы в системе, иначе лицензия на эксплуатацию не будет выдана. Чтобы получить сертификат судьи, будет требоваться ментальная подготовка. Ведь стремление приписать объекту человеческую способность мыслить всякий раз, когда мы сталкиваемся с компьютерным «разумом», невероятно сильно. Кажется, что отказ признать за ним человеческие качества — это какой-то шовинизм. Даже самые опытные пользователи системы порой поддаются искушению «подружиться» со своими инструментами, хотя бы для того, чтобы смягчить дискомфорт от выполнения обязанностей.

Нам не нужны искусственные сознательные агенты. Существует избыток естественных сознательных агентов: их достаточно для решения любых задач, предназначенных для таких особых и привилегированных существ. Нам нужны интеллектуальные инструменты. Инструменты не имеют прав и не должны испытывать чувства, которые можно ущемить, не должны отзываться негодованием на «ругательства», обрушившиеся на них со стороны неумелых пользователей.

Однажды на семинаре по искусственным агентам и автономии я поставил перед студентами задачу: представить технические характеристики робота, который может подписать гражданско-правовой договор — не в качестве суррогата владельца, а сам по себе. Речь идет не о том, чтобы заставить его понять положения или водить ручкой на листе бумаги, а о том, чтобы он обладал правовым статусом морально ответственного агента. Такие контракты не могут подписывать маленькие дети, равно как и недееспособные люди.

Проблема для роботов, которые могут захотеть достичь такого высокого статуса, состоит в том, что, подобно Супермену, они слишком неуязвимы, чтобы давать убедительные обещания. Что случится, если они откажутся от своих слов? Каким будет наказание за нарушение обещаний? Быть запертым в камере или, что более правдоподобно, разобранным? Заключение вряд ли доставит неудобство для ИИ, если мы сначала не установим для него искусственную страсть к путешествиям, которую он не сможет игнорировать или отключить самостоятельно (и было бы трудно организовать надежное решение такого рода, учитывая предполагаемую хитрость и самопознание ИИ). Демонтаж ИИ (либо робота, либо недвижимого агента, такого как Watson) не убивает его, если информация, хранящаяся в его проекте и программном обеспечении, сохраняется.

Легкость цифровой записи и передачи информации — прорыв, который позволяет программному обеспечению и данным быть фактически бессмертными, — делает роботов неуязвимыми (по крайней мере тех роботов, которых обычно представляют с цифровым софтом и памятью). Если это не очевидно, подумайте о том, как повлияло бы на человеческую мораль, если бы мы могли делать «резервные копии» людей каждую неделю. Прыгнуть вниз головой с высокого моста без страховочного троса в субботу — приключение, о котором вы не сможете вспомнить, когда в воскресенье утром восстановят вашу резервную копию, сделанную в пятницу вечером. Но после этого вы сможете насладиться видеозаписью вашей очевидной кончины.

Поэтому мы должны создавать не сознательных человекоподбных агентов, а совершенно новый вид сущности — своего рода оракулов, без совести, без страха смерти, без отвлекающей любви и ненависти, без личности (но со всеми видами слабостей и причуд, которые, без сомнения, были бы идентифицированы как «личность» системы).

Будет достаточно трудно научиться жить с ними, не отвлекая себя фантазиями о Сингулярности, в которой эти ИИ поработят нас в буквальном смысле. Предназначение людей скоро изменится — в очередной раз — навсегда, но мы можем принять контроль и ответственность за свой путь развития.

Signal vs. Noise

Signal vs. Noise Quartz

Quartz МИФ

МИФ MIT Technology Review

MIT Technology Review Backchannel

Backchannel

The Economist

The Economist

Aeon

Aeon

Альпина Паблишер

Альпина Паблишер