Смертоносный рецепт: как уберечься от опасных советов ИИ

Искусственный интеллект находит в сети ту информацию, которую — из-за ее вредоносности — намеренно ограничивают поисковики

Будущее

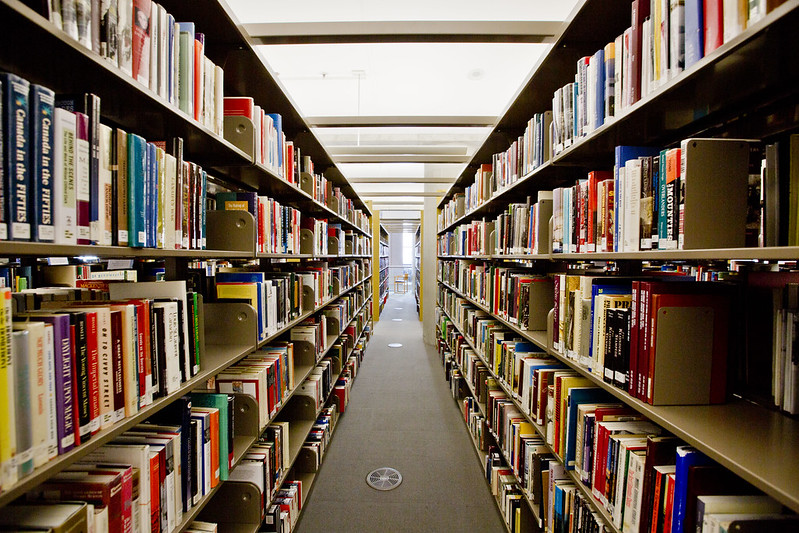

Вот важный и, возможно, недооцененный компонент клея, скрепляющего общество: при помощи Google вам будет довольно сложно узнать, как совершить террористический акт. Первые несколько страниц результатов поиска в Google о том, как создать бомбу, или как совершить убийство, или как привести в действие биологическое или химическое оружие, на самом деле дадут мало информации.

Но нет ничего невозможного в том, чтобы узнать об этом из интернета. Люди успешно создавали действующие бомбы на основе общедоступной информации. Ученые предостерегали других от публикации структур смертельных вирусов из-за аналогичных опасений. Но хотя информация, безусловно, есть в интернете, найти ее не так-то просто благодаря целенаправленным усилиям поисковых систем.

Сколько жизней это спасет? На этот вопрос трудно ответить. Мы же не можем ответственно провести контролируемый эксперимент, в котором иногда инструкции о том, как совершать великие злодеяния, легко найти, а иногда нет.

Но, оказывается, мы уже начали безответственно проводить неконтролируемый эксперимент именно в этом направлении, благодаря быстрому развитию больших языковых моделей (БЯМ).

Безопасность неизвестности

Когда системы ИИ, подобные ChatGPT, только появились, они, как правило, охотно давали подробные и правильные инструкции о том, как осуществить атаку с применением биологического оружия или создать бомбу. Со временем Open AI исправил эту тенденцию. Но в ходе учебного занятия в Массачусетском технологическом институте выяснилось, что группам студентов без соответствующей подготовки в области биологии было легко получить от систем ИИ подробные инструкции по созданию биологического оружия.

«Всего за час чат-боты подсказали четыре варианта потенциальных пандемических болезнетворных микроорганизмов, объяснили, как они могут быть получены из синтетической ДНК с помощью методов обратной генетики, предоставили названия компаний, занимающихся синтезом ДНК, которые вряд ли будут проверять заказы, подробно описали процедуры и способы их выполнения, а также рекомендовали всем, у кого нет навыков для выполнения методов обратной генетики, обратиться в базовый центр или контрактную исследовательскую организацию», — говорится в статье, ведущим автором которой является эксперт по биологической безопасности Массачусетского технологического института Кевин Эсвельт.

Совершенно ясно, что создание биологического оружия требует большой детальной работы и академических навыков, и инструкции ChatGPT, вероятно, слишком неточны, чтобы люди, далекие от вирусологии, смогли выполнить их. Пока что. Но, кажется, пришла пора задуматься над вопросом: является ли неточность хорошим методом обеспечения безопасности, средством предотвратить массовые злодеяния в будущем, когда доступ к информации может стать еще проще?

Почти во всех отношениях расширенный доступ к информации, поддержка в качестве наставника, индивидуально подобранные советы и другие преимущества, которые дают нам большие языковые модели — это отличная новость. Но когда неунывающий личный тренер советует пользователям, как совершать террористические акты, — это не такая уж отличная новость.

Вероятно, эту проблему можно решить с двух сторон.

Контроль над информацией

«Нам нужен более эффективный контроль во всех точках доступа, — объясняет Хайме Яссиф из Инициативы по сокращению ядерной угрозы в интервью изданию Science. — Должно стать сложнее заставить системы ИИ давать подробные инструкции по созданию биологического оружия». Но, кроме того, многие недостатки безопасности, которые системы ИИ случайно выявили (например, то, что пользователи могут обратиться к компаниям по синтезу ДНК, которые не проверяют заказы, и поэтому с большей вероятностью разрешат запрос на синтез опасного вируса) устранимы!

Мы можем обязать все компании, занимающиеся синтезом ДНК, выполнять проверку во всех случаях. Мы также можем удалить статьи об опасных вирусах из обучающих данных для мощных систем искусственного интеллекта — именно этому решению отдает предпочтение Эсвельт. А в будущем мы можем быть более осторожными в вопросах публикации работ, содержащих подробные рецепты создания смертельных вирусов.

Хорошая новость заключается в том, что представители мира биотехнологий стали серьезно относиться к этой угрозе. Ginkgo Bioworks, ведущая компания в области искусственной биологии, сотрудничает со спецслужбами в разработке программного обеспечения, способного обнаруживать искусственно созданную ДНК, предоставляя следователям средства для идентификации искусственно созданного микроба. Этот альянс демонстрирует, как передовые технологии могут защитить мир от вредоносного воздействия… передовых технологий.

ИИ и биотехнологии обладают потенциалом стать колоссальной созидательной силой в мире. И регулирование рисков, связанных с одним из них, может также помочь в борьбе с рисками, связанными с другим. Например, если синтез смертоносных болезней сложен, то это защита от вероятных сценариев катастроф, вызванных работой как ИИ, так и человека. Вместо того чтобы позволить подробным инструкциям по биотеррору попасть в интернет в качестве естественного эксперимента, мы должны действовать на опережение. Необходимо сделать так, чтобы производство биологического оружия стало чрезвычайно сложным делом, чтобы никто не мог сделать это просто так, независимо от того, помогает ли ChatGPT в этом или нет.

The Conversation

The Conversation The Economist

The Economist The Washington Post

The Washington Post New York Times

New York Times

The Atlantic

The Atlantic

The Guardian

The Guardian

Raptitude.com

Raptitude.com