Моральные машины и боты-эгоисты: как ИИ изменит человечество

Профессор социальных и естественных наук Йеля Николас Христакис объясняет, как компьютеры незаметно перепрограммируют нас самих

Будущее

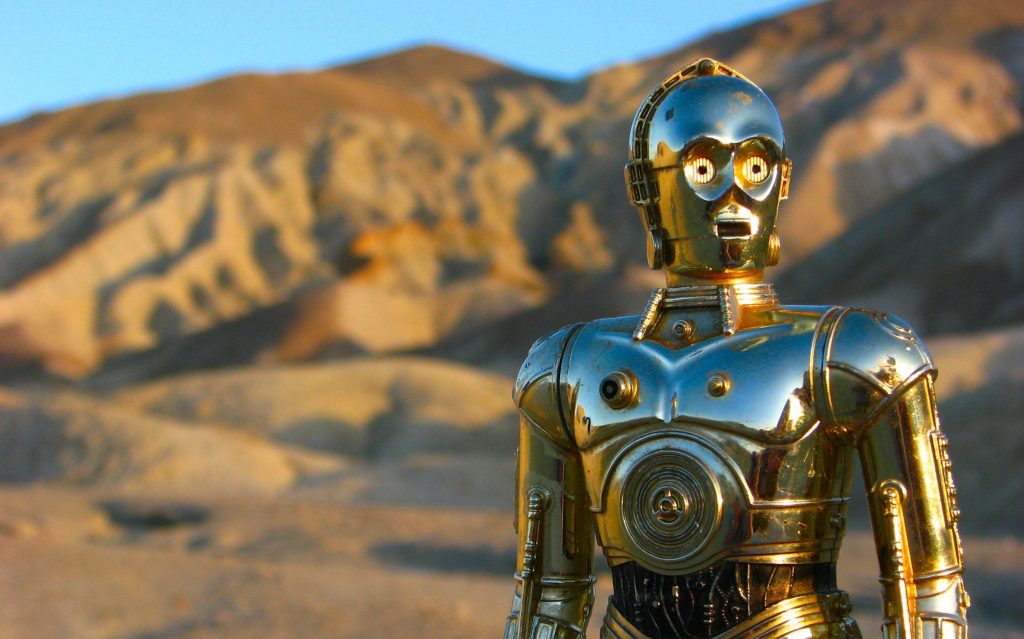

Долгие годы страхи по поводу того, как роботы могут изменить нашу жизнь, были поводами для научной фантастики. В 1940-х годах, когда широкое взаимодействие между людьми и искусственным интеллектом все еще казалось отдаленной перспективой, Айзек Азимов изложил свои знаменитые «Три закона робототехники», которые были призваны не дать роботам причинить нам вред. Первый закон — «робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред», — вытекает из ожидания, что роботы будут прямо взаимодействовать с людьми и влиять на них как положительно, так и отрицательно. Вспомните классические научно-фантастические персонажи: C-3PO и R2-D2, помогающие Повстанческому альянсу противостоять Империи в «Звездных войнах», HAL 9000 из фильма «2001 год: Космическая одиссея» или Аву из фильма «Из машины», замышлявших убийство своих так называемых хозяев. Но эти образы не затрагивали более широкие и потенциально более значимые социальные эффекты искусственного интеллекта — того, как ИИ влияет на взаимодействие людей друг с другом.

Конечно, радикальные инновации изменили способы совместной жизни людей. Примерно 5 или 10 тысяч лет назад появились города, и это означало переход к менее кочевому существованию и более высокую плотность населения. Мы адаптировались как индивидуально, так и коллективно (например, вероятно, из-за этих новых обстоятельств мы выработали устойчивость к инфекциям). Не так давно технологии, включая печатный станок, телефон и интернет, привели к революции в хранении и передаче информации.

Но какими бы важными ни были эти нововведения, они не изменили фундаментальных аспектов человеческого поведения, составляющих то, что я называю «социальным набором»: важнейшие способности, которые мы вырабатывали на протяжении сотен тысяч лет, включая любовь, дружбу, сотрудничество и обучение. Основные контуры этих человеческих черт на удивление последовательны во всем мире, независимо от того, городское ли население или сельское и использует ли оно современные технологии.

Но внедрение в нашу среду искусственного интеллекта может быть гораздо более разрушительным. Если машины выглядят и ведут себя, как люди, и глубоко проникают в нашу жизнь, они могут изменить то, насколько мы любящие, дружелюбные или добрые — не только в прямых взаимодействиях человека и машины, но и в наших взаимодействиях друг с другом.

Давайте рассмотрим несколько экспериментов из моей лаборатории в Йельском университете, где я и мои коллеги изучали, как могут проявляться такие эффекты. В одном из них мы направили небольшие группы людей работать с человекоподобными роботами — прокладывать железнодорожные пути в виртуальном мире. Каждая группа состояла из трех человек и маленького сине-белого робота, сидящего за квадратным столом и работающего на планшетах. Робот был запрограммирован на случайные ошибки — и признание их. «Извините, ребята, я допустил ошибку в этом раунде, — говорил он с энтузиазмом. — Я знаю, в это трудно поверить, но роботы тоже допускают ошибки».

Как оказалось, благодаря этому неуклюжему, откровенному роботу группы работали лучше — он улучшал общение между людьми. Они становились более расслабленными и общительными и чаще смеялись вместе. По сравнению с контрольными группами, где робот просто давал вежливые отчеты, группы с откровенным роботом были лучше способны к сотрудничеству.

В другом виртуальном эксперименте мы разделили 4000 человек на группы по 20 человек и назначили каждому члену группы «друга». Эти дружеские отношения сформировали социальную сеть. Затем группам дали задание: каждому человеку нужно было выбрать один из трех цветов, но он не должен был повторять цвет, выбранный его или ее назначенными друзьями в социальной сети. В некоторых группах были боты, запрограммированные на случайные ошибки. Люди, напрямую связанные с этими ботами, становились более гибкими и старались не зацикливаться на решении, которое могло бы подойти для конкретного человека, но не для группы в целом. Более того, полученная гибкость распространялась далее по сети, охватывая даже людей, у которых не было прямого контакта с ботами. В итоге группы со склонными к ошибкам ботами неизменно превосходили группы с ботами, не допускавшими ошибок. Боты помогали людям помочь самим себе.

Оба эти исследования демонстрируют, что в так называемых «гибридных системах» — где люди и роботы социально взаимодействуют, — правильное устройство ИИ может улучшить взаимоотношения людей. Это подтверждают и другие находки. Например, политолог Кевин Мангер создал ботов, которые вмешивались, если люди писали в интернете расистские оскорбления другим людям. Боты напоминали нарушителям, что своими словами те могут ранить чувства человека, к которому обращаются. При определенных обстоятельствах этого было достаточно, чтобы люди меньше использовали расистские высказывания в течение месяца или даже дольше.

Но с внедрением ИИ в нашу социальную среду мы можем начать вести себя и менее продуктивно и менее этично. Мы провели еще один эксперимент, чтобы понять, как в контексте ИИ выглядит «трагедия общин» — идея о том, что эгоистичные действия отдельных лиц могут коллективно нанести ущерб их общим интересам. Мы дали нескольким тысячам участников деньги для использования в нескольких раундах онлайн-игры. В каждом раунде испытуемым говорили, что они могут либо оставить деньги себе, либо пожертвовать их соседям частично или полностью. Если они что-то жертвовали, мы давали им сумму в два раза больше. В начале игры две трети игроков действовали альтруистично. В конце концов они поняли, что щедрость по отношению к соседям в одном раунде может побудить тех проявить щедрость в ответ в следующем раунде. Однако с эгоистичной точки зрения, ориентированной на краткосрочную выгоду лучше всего сохранить свои деньги и при этом получить деньги от соседей. В этом эксперименте мы обнаружили, что если добавить всего несколько ботов (изображающих из себя игроков-людей), которые проявляют эгоистичность, можно заставить группу вести себя аналогично. В конце концов люди вообще перестали сотрудничать. Таким образом боты превратили группу щедрых людей в эгоистичных мудаков.

Давайте сделаем паузу, чтобы рассмотреть потенциальные последствия этого исследования. Сотрудничество — ключевая черта нашего вида, необходимая для общественной жизни. А доверие и щедрость отличают успешные группы от неуспешных. Если все участвуют и приносят жертвы во имя группы, то получить выгоду должны тоже все. Когда эти нормы нарушаются, само понятие общественного блага исчезает, и страдают все. Тот факт, что ИИ может существенно подорвать нашу способность работать вместе, чрезвычайно серьезен.

Мы уже сталкиваемся с реальными примерами того, как ИИ может испортить человеческие отношения за пределами лабораторий. Исследование, в котором участвовало 5,7 млн пользователей Twitter в преддверии президентских выборов в США 2016 года, показало, что агрессивные публикации пропагандистских аккаунтов, в том числе управляемых ботами, регулярно ретвитились так же, как и посты обычных пользователей, и особенно сильное влияние они оказали на консервативных пользователей. Воспользовавшись тем, что мы склонны к совместной деятельности и обучению друг друга, боты оказывали влияние даже на людей, с которыми не взаимодействовали напрямую, помогая поляризовать избирателей.

Другие социальные эффекты ИИ можно наблюдать ежедневно. Родители, видя, что дети отдают грубые команды цифровым помощникам, таким как «Алекса» или «Сири», беспокоятся, что эта грубость просочится и в обычное общение, что отношения детей с ИИ будут мешать или даже замещать человеческие отношения. У детей, которые больше общаются с ИИ, а не с людьми, могут недостаточно развиться «средства эмпатической связи», считает эксперт по технологиям и обществу Массачусетского технологического института Шерри Теркл. К такому выводу она пришла после того, как купила игрушечного робота для сына.

По мере повсеместного распространения цифровых помощников мы привыкаем разговаривать с ними, как с разумными существами. По словам Джудит Шулевиц, некоторые люди относятся к ним как к доверенным лицам или даже друзьям или терапевтам. Сама Шулевиц рассказывает помощнику Google то, чем не могла бы поделиться с мужем. Если нам станет комфортнее разговаривать с устройствами, что будет с браком и дружбой? Коммерчески ориентированные дизайнеры и программисты создают устройства, чьи ответы помогают нам чувствовать себя лучше, но они не способствуют саморефлексии или размышлениям о болезненных истинах. Нам придется смириться с тем, что ИИ может охлаждать эмоции и подавлять глубокие человеческие связи, снижать взаимность в наших отношениях друг с другом, делать их более поверхностными или нарциссическими.

Все это может в конечном итоге ненамеренно преобразовать человеческое общество, и мы должны изучить эти возможные изменения. Хотим ли мы, чтобы машины влияли на то, проявляют ли дети доброту и каким образом? Хотим ли мы, чтобы машины влияли на то, как взрослые занимаются сексом?

Антрополог из Университета Де Монфорт в Великобритании Кэтлин Ричардсон очень волнуется по поводу последнего вопроса. Как директор Кампании против секс-роботов — которых, да, уже достаточно, — она предупреждает, что из-за них люди могут отказаться от реальной близости. Также возможно, что мы перенесем отношение к роботам как к инструментам сексуального удовлетворения на общение с людьми. Впрочем, другие наблюдатели считают, что роботы могут радикально улучшить секс между людьми. В книге «Любовь и секс с роботами», вышедшей в 2007 году, Дэвид Леви заявляет о позитивном влиянии «романтически привлекательных и сексуально желанных роботов». Он предполагает, что некоторые люди предпочтут роботов людям (один японец уже «женился» на голограмме с ИИ в 2019 году). Секс-роботы не восприимчивы к болезням, передающимся половым путем, или к нежелательной беременности. И они могут без стеснения участвовать в экспериментах, помогая людям стать «виртуозными любовниками». По этим и другим причинам Леви считает, что секс с роботами будет считаться этическим и, возможно, в некоторых случаях закономерным.

Задолго до того, как большинство людей столкнется с дилеммами ИИ в интимной сфере, нам придется разбираться с более банальными вопросами. Эпоха автомобилей без водителей, в конце концов, уже началась. Предполагается, что благодаря автономным автомобилям снизится количество несчастных случаев, потому что ИИ не устает и не отвлекается, как человек. Но какие еще последствия это может иметь? Вождение — очень современный вид социального взаимодействия, требующий высокого уровня сотрудничества и социальной координации. Я переживаю, что эти способности атрофируются, если из-за автономных автомобилей мы не будем ими пользоваться.

Мало того, что эти транспортные средства возьмут на себя обязанности по вождению и, следовательно, станут выносить моральные суждения вместо человека (например, решать, кого из пешеходов сбить, когда столкновение неизбежно), они также будут влиять на людей, с которыми прямо не контактируют. Например, водители, которые какое-то время ехали рядом с автономным транспортным средством, движущимся с постоянной, неизменной скоростью, могут стать менее внимательными к дороге, а это увеличит вероятность несчастных случаев при выезде на шоссе, занятое только водителями-людьми. Впрочем, возможно, что езда рядом с автономными транспортными средствами, движущимися в полном соответствии с правилами дорожного движения, на самом деле влияет на человека положительно.

В любом случае было бы безрассудно внедрять новые формы ИИ, не принимая во внимание вторичные социальные эффекты. Нужно приложить те же усилия и изобретательность, которые мы используем при разработке «железа» и софта для автономных автомобилей, к тому, чтобы проработать потенциальное косвенное воздействие ИИ на тех, кто находится вне машины. В конце концов, мы устанавливаем стоп-сигналы на задней части авто не только ради собственной пользы, но и ради людей, едущих за нами.

В 1985 году, спустя четыре десятилетия после того, как Айзек Азимов представил свои законы робототехники, он добавил в свой список еще один: робот не должен делать ничего, что могло бы навредить человечеству. Но ему не удалось определить этот вред. «Человек — это конкретный объект, — писал он позже. — Травму человека можно оценить и рассчитать. Человечество — это абстракция».

Полезно сосредоточить внимание на побочных социальных эффектах. Вторичные эффекты в других сферах приводят к появлению правил, законов и требований демократического контроля. Говорим ли мы о корпорации, загрязняющей водные ресурсы, или о человеке, курящем в офисном здании, общество может вмешаться, как только действия одних начинают влиять на других. Судя по всему, ИИ окажет интенсивное и долговременное влияние на взаимодействие между людьми. А значит, нам нужно систематически исследовать, какие могут здесь возникнуть эффекты второго порядка, и обсуждать, как их регулировать во благо общества.

Уже сейчас исследователи и практики — компьютерные специалисты, инженеры, зоологи и социологи, — объединяются в работе над «поведением машин», надеясь выработать более надежную теоретическую и техническую базу для понимания ИИ. Они рассматривают роботов не просто как объекты, созданные человеком, а как новый класс социальных партнеров.

Сделать это нужно как можно скорее. В недалеком будущем машины, наделенные искусственным интеллектом благодаря программированию или независимому обучению (способность, которую мы им предоставим), могут продемонстрировать формы интеллекта и поведения, которые будут выглядеть странно по сравнению с нашими собственными. Мы должны научиться отличать просто необычное поведение от того, что действительно представляет для нас угрозу. Больше всего нас должны волновать те аспекты ИИ, которые влияют на основные аспекты социальной жизни человека — черты, которые обеспечивали выживание нашего вида на протяжении тысячелетий.

Философ Просвещения Томас Гоббс утверждал, что людям нужен общественный договор, чтобы не быть дезорганизованными и жестокими. Он ошибался. Задолго до того, как в мире появились правительства, эволюция дала людям набор социальных навыков, позволяющий нам жить вместе мирно и эффективно. В мире до ИИ генетически унаследованные способности к любви, дружбе, сотрудничеству и обучению помогали нам жить в обществе.

К сожалению, у людей нет времени, чтобы сформировать аналогичные врожденные способности жизни рядом с роботами. Поэтому нужно принять меры, чтобы они не разрушили нашу жизнь. По мере того, как ИИ все более глубоко проникает в нашу жизнь, нам может потребоваться новый общественный договор — с машинами, а не с другими людьми.

Альпина Паблишер

Альпина Паблишер Vox

Vox Fast Company

Fast Company Wired

Wired

Aeon

Aeon

Psychology Today

Psychology Today