Нечеловеческие решения: кого принесет в жертву беспилотный автомобиль?

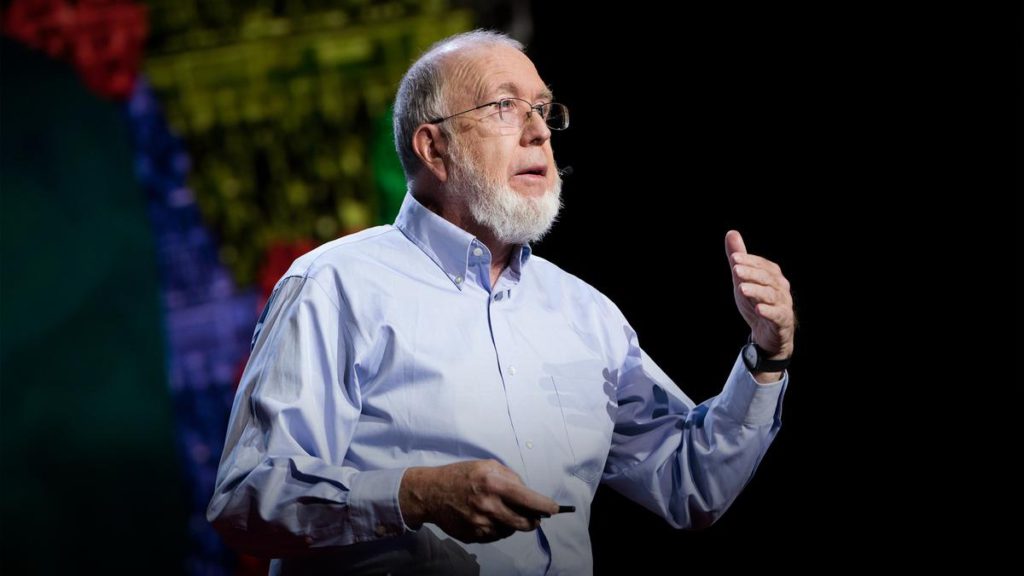

Поведенческий экономист и психолог Дэн Ариели изучает, какими принципами должен руководствоваться искусственный разум в условиях морального выбора

Будущее

Технологии вокруг нас становятся умнее. Намного умнее. И эта возрастающая разумность приносит много пользы людям и обществам. В частности, более разумные технологии означают, что им можно позволить принимать более эффективные решения вместо нас, а сами мы можем наслаждаться результатами принятия правильных решений без необходимости прилагать усилия. Все это звучит потрясающе — лучшие решения с меньшими усилиями. Однако одна из проблем заключается в том, что решения иногда подразумевают моральные компромиссы, и в этих случаях мы должны задаться вопросом, готовы ли мы доверить эти моральные решения нечеловеческой системе.

Один из самых ярких примеров таких моральных решений связан с автономными транспортными средствами. Беспилотные автомобили решают, по какой полосе следует ехать или кому уступить дорогу на оживленном перекрестке. Но они также должны принимать гораздо более сложные с моральной точки зрения решения — например, игнорировать ли правила дорожного движения, когда их просят срочно ехать в больницу, или выбирать, чья безопасность должна быть приоритетной в случае неизбежной аварии. Принимая это во внимание, становится ясно, что передать возможность принимать решения не так просто, и для этого требуется хорошая модель нашей собственной морали, если мы хотим, чтобы беспилотные автомобили принимали решения вместо нас.

Это подводит нас к основному вопросу: как нужно проектировать искусственный разум с точки зрения основных этических принципов? Какой руководящий принцип мы должны использовать для этих искусственных машин? Например, должны ли эти машины ставить интересы своих владельцев выше других? Или рассматривать всех живых существ как равных? Какой автомобиль вы хотели бы видеть у себя и у своего соседа?

Мы использовали экспериментальный подход, чтобы выявить общие знаменатели и потенциальные предрассудки человеческого разума в таких ситуациях. В наших экспериментах мы опирались на проект The Moral Machine и использовали вариант классической дилеммы вагонетки — мысленный эксперимент, в котором людей просят выбрать между нежелательными результатами в разных условиях. В наших дилеммах людям, принимающим решения, было предложено выбрать, кем должен пожертвовать автономный автомобиль в случае неизбежной аварии: пассажирами транспортного средства или пешеходами на улице. Результаты опубликованы в открытом доступе и доступны всем.

Если коротко, мы обнаружили две предвзятости, которые влияют на выбор жертвы (пешеход или пассажиры). Первая предвзятость связана со скоростью принятия решения. Мы выяснили, что быстрые, интуитивные моральные решения ведут к убийству пассажиров независимо от конкретной структуры дилеммы, в то время как при взвешенных, вдумчивых решениях люди склонны чаще жертвовать пешеходами. Вторая предвзятость связана с первоначальной точкой зрения лица, выносящего суждение. Те, кто начинал с заботы о пассажирах, чаще жертвовали пешеходами, и наоборот. Интересно, что в целом и в разных условиях люди предпочитают спасать пассажиров, а не пешеходов.

Что мы поняли из этих экспериментов и The Moral Machine, так это то, что нам необходимо принять какие-то решения. Хотим ли мы, чтобы автономные автомобили отражали нашу собственную мораль и предубеждения или хотим, чтобы их моральный взгляд был таким же, как у Дейты из сериала «Звездный путь»? И если эти машины будут имитировать нашу собственную мораль, хотим ли мы, чтобы это была мораль, основанная на непосредственных интуитивных чувствах или опирающаяся на те чувства, которые проявляются после некоторых раздумий над моральной дилеммой?

Эти вопросы могут показаться академическими или философскими дебатами, но скорость, с которой приближаются автономные транспортные средства, говорит о том, что вопросы эти важны и актуальны для проектирования нашего совместного с технологиями будущего.

МИФ

МИФ Vox

Vox Wired

Wired Quartz

Quartz

Big Think

Big Think

Кевин Келли

Кевин Келли

The Washington Post

The Washington Post